Architecture du Risque - Pourquoi la Conformité IA Doit Devenir une Fonction Système industrielle

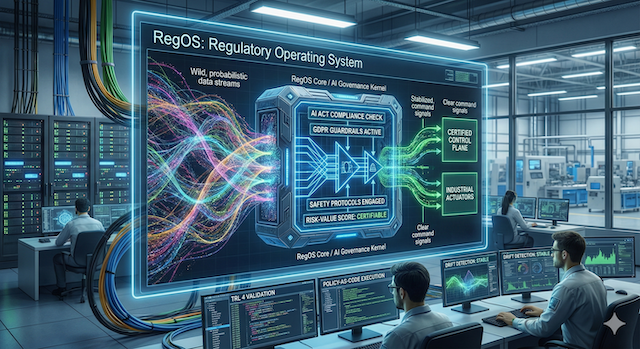

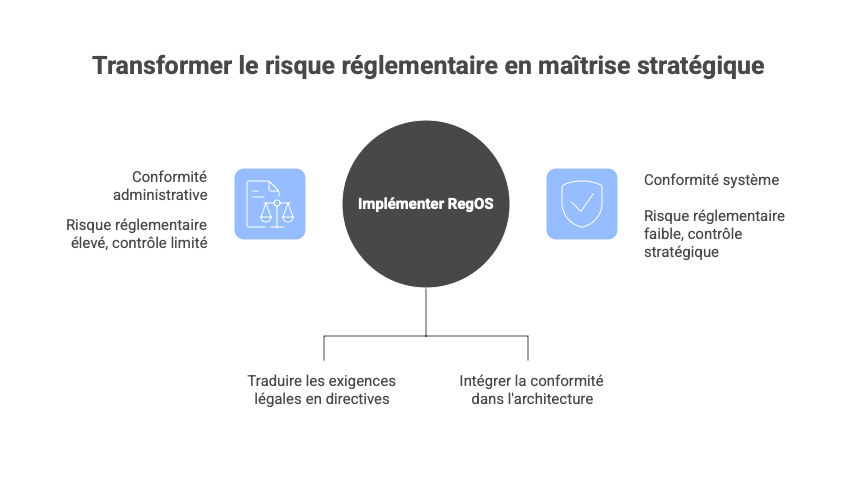

Dans un monde où l'IA et l'humain collaborent déjà (Gartner Strategic Tech 2026 Trend 7 et 8), traiter la conformité comme un simple département administratif est devenu une illusion dangereuse. Elle doit devenir une fonction système, codifiée au cœur de l'architecture, pour transformer le risque en maîtrise stratégique. Plus qu’un simple module, nous devons concevoir un Regulatory Operating System (RegOS) : un noyau de contrôle capable d'orchestrer les exigences légales complexes (AI Act, RGPD, NIS2) et de les traduire en directives techniques exploitables par le système en temps réel.

Pourtant, dans l’imaginaire collectif, la conformité reste souvent perçue comme un frein administratif, un passage obligé en fin de projet qui alourdit l’innovation sans apporter de valeur réelle. Cette vision constitue une erreur stratégique profonde et dangereuse. L’IA ne se déploie plus comme un logiciel statique traditionnel, mais comme un agent dynamique dont le comportement évolue en continu, influencé par des données massives et des interactions imprévisibles.

Dans l’industrie, qu’il s’agisse d’aéronautique, d’automobile, d’énergie, de défense ou d’infrastructures critiques, cette transformation est encore plus radicale. Les systèmes IA ne sont jamais isolés : ils s’intègrent dans des architectures complexes, multi-composants, régies par des cycles en V, des exigences de sûreté, de testabilité, et des preuves formelles. Un algorithme ne vaut rien s’il n’est pas insérable dans le tissu des processus existants : ingénierie système, qualité, sécurité, cybersécurité.

Traiter la conformité par des checklists ponctuelles équivaut à installer des freins sur une Formule 1 en pleine course : trop tardif, inefficace, et potentiellement catastrophique.

La thèse centrale est claire et impérative : la conformité IA ne peut plus être confinée à un département isolé, souvent relégué au Legal ou à la Compliance, intervenant tardivement avec des audits manuels. Elle doit devenir une fonction système intégrée, une infrastructure d’ingénierie codifiée au cœur du code, capable d’évaluer, d’autoriser ou de bloquer des actions en temps réel. Cette logique englobe les modèles de perception (vision, sons, capteurs), les systèmes embarqués (edge AI, temps réel), les modèles de scoring et de décision, les agents autonomes multi-étapes, les modèles de recommandation, les IA hybrides (ML + règles déterministes), et bien sûr, les IA génératives.

Cette transformation n’est pas un luxe éthique ; elle représente la conversion du risque réglementaire en avantage concurrentiel durable. En 2026, avec l’entrée en vigueur progressive de l’EU AI Act, dont les obligations pour les systèmes à haut risque (AI Act Timeline, Trilateral AI Act Mapping) s’appliquent pleinement à partir d’août 2026, cette approche devient une nécessité absolue pour éviter des amendes pouvant atteindre 7 % du chiffre d’affaires mondial annuel.

Pour l'industriel, cette fonction système ne doit pas être une simple couche logicielle supplémentaire, mais une enveloppe déterministe entourant un moteur probabiliste. Au stade TRL 4 (validation en laboratoire), le RegOS doit agir comme un garde-fou capable de garantir que, peu importe l'instabilité du modèle IA, les sorties restent dans un "plan de contrôle" sécurisé et certifiable, réconciliant ainsi l'imprévisibilité de l'apprentissage machine avec la rigueur des automates industriels.

C'est un début de réponse que nous pourrions donner à Dario Amodei (CEO d'Anthropic) quand il évoque ces inquiétudes:

"I worry a lot about the unknowns. I don't think we can predict everything for sure. But precisely because of that, we're trying to predict everything we can. We're thinking about the economic impacts of AI. We're thinking about the misuse. We're thinking about losing control of the model."

La Grande Erreur Actuelle : Confondre Conformité Administrative et Gouvernance Technique

La plupart des organisations abordent encore la conformité IA comme un bureau des limites, une équipe qui valide ou bloque un projet après coup. Cette méthode héritée des régulations traditionnelles traite la conformité comme un coût à minimiser, appliqué via des audits ponctuels et des checklists statiques.

Pourtant, face à la volatilité des systèmes autonomes et des LLM, cette approche est obsolète et expose à des risques systémiques majeurs.

Elle est encore plus insuffisante pour les IA intégrées dans des systèmes critiques où :

- chaque exigence doit être tracée,

- chaque choix doit être justifié,

- chaque modèle doit être versionné,

- chaque performance doit être démontrée dans des environnements représentatifs.

Des incidents comme ceux survenus chez Google avec Bard en 2023 ou chez OpenAI entre 2023 et 2024, impliquant fuites de données sensibles en santé et finance, démontrent cruellement que le risque n’attend pas la fin du développement (OPenAI, Google).

C’est précisément cette approche tardive et administrative de la conformité qui conduit la majorité des initiatives IA à mourir dans ce que les ingénieurs appellent la Vallée de la Mort.

En 2025, le bilan de l'IA en entreprise est un cimetière de PoC (MIT State of AI 2025, NIST AI RMF 2025 Updates). Selon les données du MIT et de S&P Global, 95 % des investissements en IA générative n’ont généré aucun ROI tangible (XRay.Tech Failure Rate). Le constat est brutal : sur les 60 % d'entreprises ayant évalué des systèmes d'IA de classe industrielle, seules 5 % ont réussi à passer à l'échelle de la production (BCG). Pourquoi ? Parce que la majorité de ces projets sont des "expériences de laboratoire" dépourvues de toute architecture de preuve. L'innovation sans gouvernance n'est pas un progrès, c'est un gaspillage de capital qui alimente une dette cognitive insoutenable pour l'industrie : l’innovation IA ne manque pas de créativité mais de gouvernance, de preuves et d’intégrabilité (Stanford HAI Index 2025 - Takeaway 5).

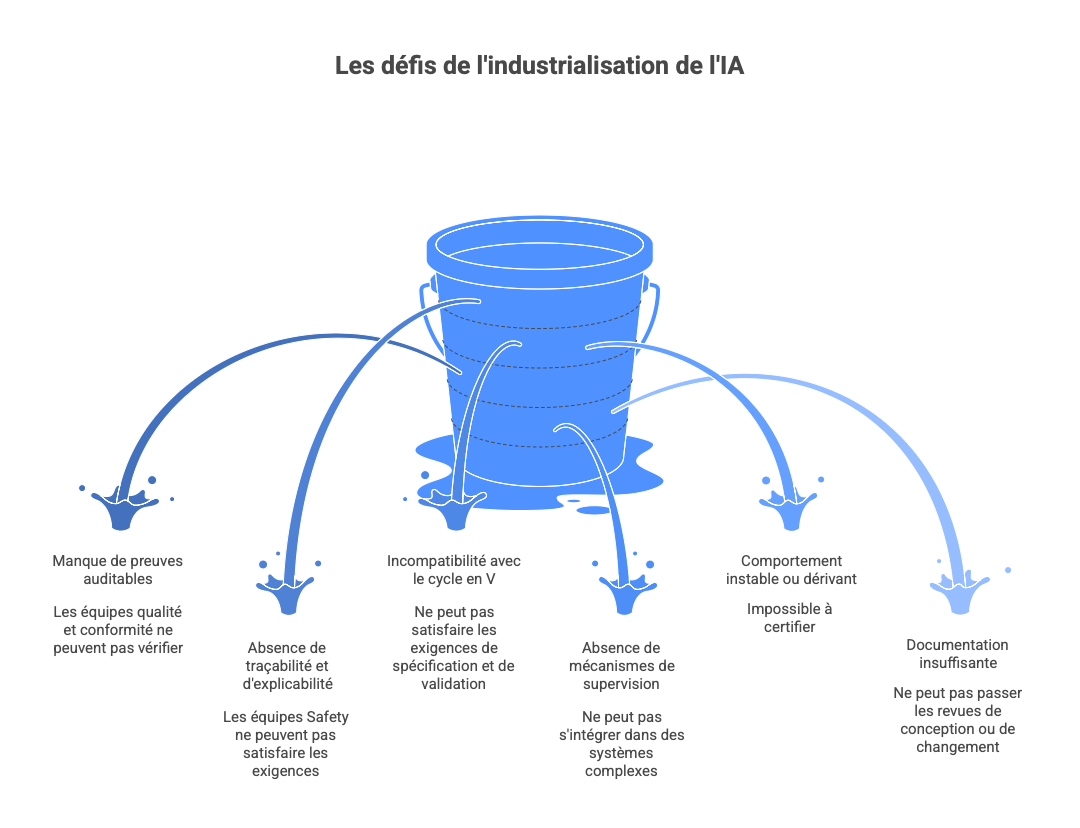

Le constat est sans appel, plus un asset IA est innovant, plus il meurt vite lorsqu’il rencontre pour la première fois les exigences réelles du monde industriel :

- incapacité à produire des preuves auditables pour les équipes qualité et conformité,

- absence de traçabilité et d'explicabilité pour satisfaire les équipes Safety,

- incompatibilité avec les exigences du cycle en V (spécification → validation),

- absence de mécanismes de supervision ou de garde-fous permettant son intégration dans un système complexe,

- comportement instable ou dérivant impossible à certifier,

- documentation insuffisante pour passer les revues de design ou de changement.

C’est cela, la Vallée de la Mort : le gouffre qui sépare un prototype séduisant d’un actif réellement industrialisable, maintenable, observable, certifiable, et déployable dans un environnement critique.

Et ce gouffre est également directement alimenté par le fait que la conformité est encore traitée comme une activité de fin de chaîne.

Le renversement mental s’impose : la conformité ne se "fait" plus, elle s’implémente comme un firewall distribué, un authenticator intégré à l’architecture, ou un scheduler optimisant les ressources en temps réel. L’IA agit comme une entité probabiliste en continu ; la conformité doit devenir son contrepoids algorithmique automatisé.

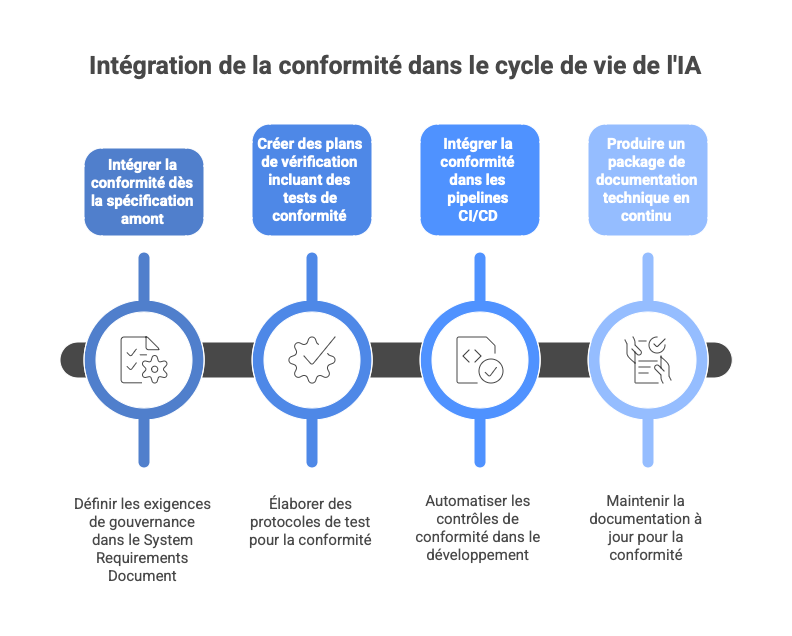

Dans les environnements régulés, cela signifie notamment :

- intégrer la conformité dès la spécification amont,

- définir des exigences de gouvernance dans le System Requirements Document,

- créer des Verification Plans incluant des tests de compliance,

- intégrer la conformité dans les pipeline CI/CD

- et produire un Technical Documentation Package en continu, et non en fin de cycle.

Autrement dit : seule une conformité pensée comme une fonction système – conçue dès la conception, intégrée dans les pipelines, automatisée, traçable – permet de franchir la Vallée de la Mort et de transformer l’innovation IA en actifs réellement industrialisables.

Ce shift-left est dicté par les régulations modernes : l’EU AI Act exige des contrôles continus pour les systèmes à haut risque. Le NIST AI Risk Management Framework (RMF 1.0, janvier 2023) impose une logique itérative de "govern - map - measure - manage" tout au long du cycle de vie. Enfin, la norme ISO/IEC 42001:2023, premier standard international pour les systèmes de management de l’IA, préconise explicitement l’intégration de contrôles automatisés dans les processus d’ingénierie (ISO 42001 Guide 2025, ISO 42001 Training 2025).

Le franchissement de la Vallée de la Mort nécessite également une convergence avec l'Ingénierie Système Basée sur les Modèles (MBSE). La conformité ne peut plus être une réflexion après coup ; elle doit être modélisée dès le TRL 3. Cela signifie transformer les exigences de l'AI Act en exigences système (System Requirements) injectées directement dans des outils comme DOORS ou Capella.

De la Checklist Statique à l’Infrastructure de Contrôle Continue : Le Policy-as-Code

L’approche traditionnelle d’audit post-développement est morte avec l’émergence des LLM et des agents autonomes. Le risque est désormais trop volatil pour être géré manuellement. Les entreprises doivent migrer vers une conformité opérationnelle, intégrant des garde-fous directement dans les pipelines MLOps, les chaines CI/CD et les couches applicatives.

Dans les organisations agiles, cette migration se traduit par :

- l’intégration des exigences AI Act dans le backlog,

- des user stories enrichies d’acceptance criteria réglementaires,

- un Definition of Done qui exige des preuves (tests, logs, évaluation),

- des enablers Agile dédiés aux contrôles IA,

- la présence d’un Architecte Conformité IA dans les cérémonies clés (PI Planning, System Demos).

Dans un cadre Agile, cette infrastructure doit évoluer vers un modèle de "Compliance-as-a-Service" (Forrester ERP Agents 2026, 8allocate-Stay Compliant with EU AI Act). Plutôt que d'être un frein lors de la System Demo, le RegOS doit automatiser la production de preuves réglementaires à chaque Sprint. La conformité devient alors un artefact systématique de la Definition of Done (DoD). Cela permet aux équipes de développement de corriger les dérives de biais ou de performance en temps réel, évitant ainsi la congestion du train (ART) lors des phases de mise en service.

Ainsi, le "Policy-as-Code", où les obligations réglementaires sont traduites en règles exécutables.

Concrètement, un système doit auto-classifier les cas d’usage : analyser la nature des données traitées (sensibles, biométriques, enfants), la finalité des outputs, et le contexte d’utilisation pour déterminer automatiquement le niveau de risque (haut risque selon l’Annex III de l’AI Act, par exemple en santé, crédit, recrutement ou infrastructures critiques). Un filtrage en temps réel intervient ensuite : si une IA générative produit un contenu biaisé ou manipule des données sensibles, un “Supervisor” intercepte la réponse avant livraison à l’utilisateur. Des outils open-source comme Guardrails AI ou NeMo Guardrails facilitent cette implémentation en validant inputs/outputs.

Le Policy-as-Code constitue le langage de programmation de ce RegOS. Plutôt que de subir des audits manuels, l’industriel déploie un moteur de règles (Kernel) qui agit comme une couche d’abstraction. Ce moteur intercepte les flux de données et les décisions de l’IA pour garantir que chaque action reste dans l'enveloppe de vol réglementaire, assurant ainsi une conformité par design et non par réaction.

Cette infrastructure s’aligne sur le NIST AI RMF, qui insiste sur une gestion itérative et continue des risques (ISO 42001 Training 2025). Elle intègre également des pratiques comme le red teaming automatisé pour tester la robustesse, révélant des vulnérabilités avant déploiement.

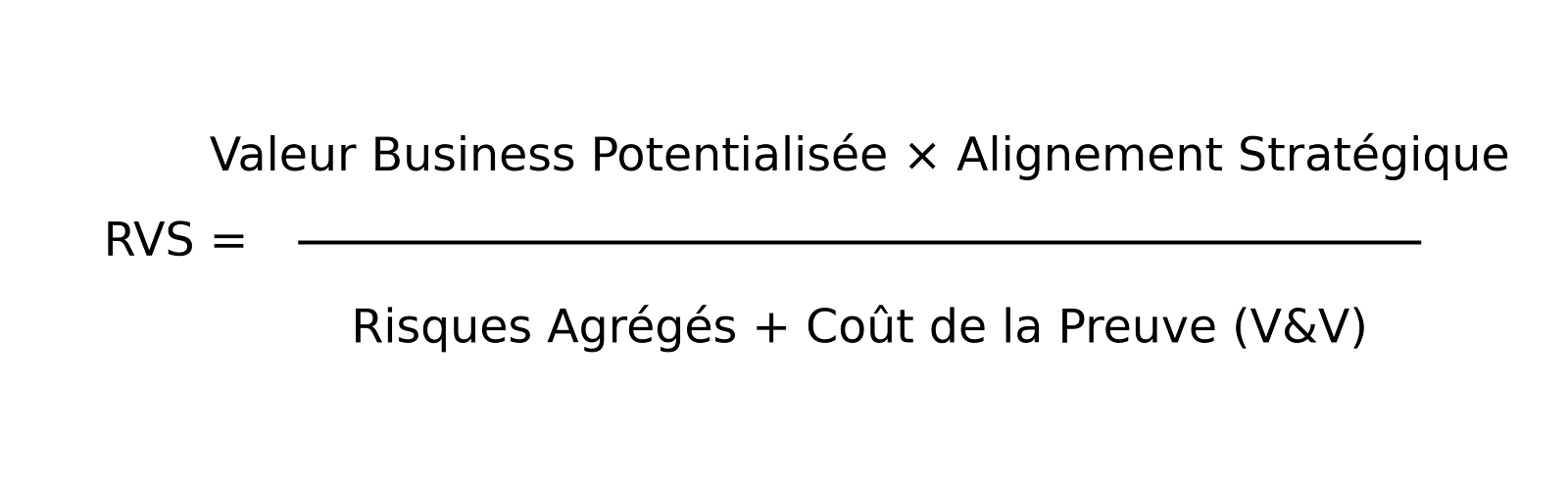

Le Risk-Value Score (RVS) : L’Arbitrage Stratégique comme Boussole

Le Risk-Value Score (RVS) est l'outil d'arbitrage du RegOS. Il permet de passer d'une intuition subjective ("ce projet est prometteur") à une mesure objective de la viabilité industrielle : le rôle des décideurs n’est pas d’éliminer tout risque, mais de l’arbitrer froidement. Un projet peut présenter une valeur immense, mais si la démonstration de sa sûreté de fonctionnement nécessite des campagnes de tests au coût prohibitif, son RVS chute. Ce score dynamique guide l’allocation des ressources.

Pour sortir du "Théâtre de l'Innovation", le calcul ne doit plus se limiter au simple ROI, mais intégrer le coût de la confiance :

- Valeur Business Potentialisée : Gain d'efficience, nouveaux revenus ou création d'un avantage concurrentiel (Moat).

- Alignement Stratégique (Le filtre anti-théâtre) : Coefficient de 0 à 1 mesurant si le projet résout un problème métier réel ou s'il n'est qu'une démonstration technique (« AI Theater »).

- Risques Agrégés : Somme des expositions juridiques (amendes AI Act jusqu'à 7%), éthiques, cyber et réputationnelles.

- Coût de la Preuve (V&V) : Budget nécessaire pour la vérification, la validation, la certification et la génération automatique de la documentation technique.

L'utilisation du RVS permet de catégoriser les projets dès le stade TRL 4 (validation en laboratoire) pour éviter d'engager des budgets d'industrialisation inutiles :

| Score | Catégorie | Action Stratégique |

|---|---|---|

| Élevé | Actif Industriel | Investissement Prioritaire. Risque maîtrisé et valeur forte. On automatise le pipeline DevSecMLOps immédiatement. |

| Moyen | Zone de Pivot | Optimisation requise. Soit réduire le risque (en changeant de modèle), soit réduire le coût de la preuve via le RegOS. |

| Faible | Impasse / Théâtre | Arrêt Immédiat (Kill Switch). Souvent des projets "cool" mais impossibles à certifier ou sans ROI réel (ex: Chatbot interne sur données sensibles). |

Exemple concret d'arbitrage :

- Projet A (Assistant RH de tri de CV) : Valeur élevée, mais Risque (discrimination) et Coût de la preuve (auditabilité humaine exigée par l'AI Act) massifs. RVS faible Abandon ou Pivot.

- Projet B (Maintenance prédictive industrielle) : Valeur forte, Risque modéré (enveloppe déterministe simple), Coût de la preuve standardisé. RVS élevé Accélération.

Dans l’industrie, le RVS a une autre fonction essentielle : il devient un "gate formel" permettant d’arrêter un développement avant qu’il ne devienne trop coûteux. Dans les cycles en V, il peut être intégré :

- aux revues d’avancement,

- aux Safety Reviews,

- aux Change Control Boards,

- aux décisions de bascule prototype → industrialisation.

Cet arbitrage permet d'identifier dès le TRL 4 les projets "incertifiables" avant qu'ils n'engloutissent des budgets d'industrialisation inutiles. Trop d’initiatives IA échouent car elles sont “cool mais inutiles” ou “ambitieuses mais suicidaires juridiquement”. Les projets à faible value mais forte exposition (chatbot marketing sur données sensibles) obtiennent un RVS bas et doivent être tués rapidement. À l’inverse, ceux à haute value et risque maîtrisable (détection de fraude en assurance) passent en priorité (FSB AI Vulnerabilities 2025).

Impacts Techniques : Construire la Couche de Supervision

La conformité devient un composant d’architecture natif. Créez un microservice de classification automatique renvoyant catégorie de risque (AI Act), sensibilité des données, et obligations de contrôles. Intégrez des contrôles de conformité dans le pipeline ML et CI/CD : traçabilité versionnée, journalisation, tests de robustesse, détection de drift et biais, red teaming automatisé.

Enrichissez la couche applicative d’un "Risk Policy Engine" évaluant en continu contexte utilisateur, modèle, action demandée et risque de sortie. L’IA n’est plus un monolithe opaque, mais une série de compartiments contrôlés. Des outils comme ceux inspirés de Zero Trust appliqués à l’IA assurent cette surveillance.

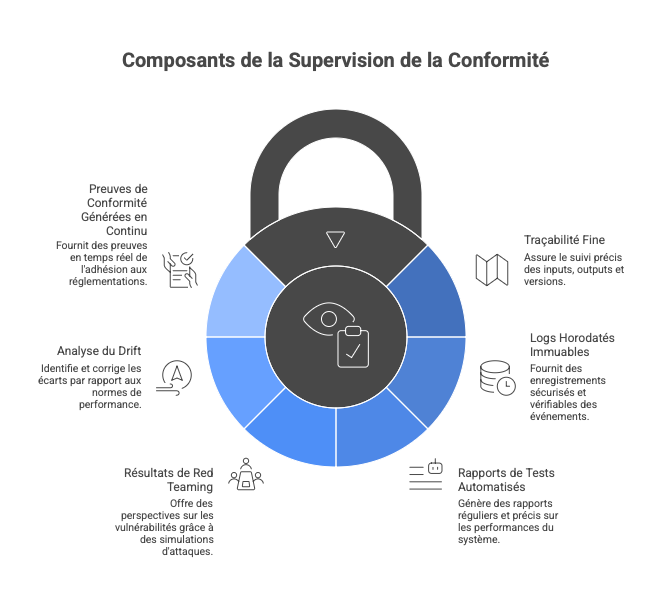

Pour être admissible en audit (AI Act, ISO 42001, Safety), la couche de supervision doit produire :

- une traçabilité fine (inputs, outputs, versions),

- des logs horodatés immuables,

- des rapports de tests automatisés,

- les résultats de red teaming,

- une analyse du drift,

- et des preuves de conformité générées en continu.

Ces artefacts nourrissent :

- les revues techniques,

- les dossiers de certification,

- les audits internes et externes.

Il est temps de rompre avec l'illusion de l'IA "cloud-native" universelle. Un simple "wrapper" autour d'un modèle généraliste ne passera jamais le filtre des certifications critiques. La différence entre un gadget et un actif industriel réside dans cette enveloppe déterministe : si vous ne pouvez pas prouver la sûreté de fonctionnement votre IA reste un risque de cybersécurité béant et un passif juridique.

L’Architecture du RegOS est le Bus de Données Réglementaire ne devant pas être une surcouche isolée, mais un bus de données intégré. Il s'interface avec vos outils de PLM (Product Lifecycle Management) et d'ALM (Application Lifecycle Management) pour :

-

Automatiser la Preuve : Générer en continu le Technical Documentation Package exigé par l'AI Act.

-

Qualifier les Outils : Assurer que les garde-fous (guardrails) sont eux-mêmes certifiables selon les normes de sûreté

-

Isoler les Risques : Garantir que si le modèle IA (probabiliste) dérive, le RegOS (déterministe) maintient le système dans un état sûr. »

Cette architecture de supervision doit impérativement tenir compte des contraintes SWaP (Size, Weight, and Power), particulièrement pour l'IA embarquée (Edge AI - Arm Edge AI Trends 2026). Au stade TRL 6, le RegOS ne peut pas être un service cloud gourmand. Il doit être conçu comme un micro-noyau ultra-léger, capable d'exécuter des contrôles de conformité et de sécurité directement sur le matériel cible (FPGA, microcontrôleurs) sans dégrader les performances temps réel du système critique.

Impacts Business et Légaux : Le Haut Risque comme Moat Compétitif

Contrairement à l’instinct d’évitement, les zones haut risque de l’AI Act (biométrie, éducation, justice, finance) sont les territoires les plus lucratifs. Seuls les acteurs maîtrisant une conformité continue - avec documentation complète, monitoring post-marché et reporting d’incidents - y opèrent. Cela crée un moat réglementaire stable : barrière à l’entrée prohibitive pour les concurrents, comme les licences bancaires ou certifications médicales.

La complexité devient avantage : une fois certifié ISO/IEC 42001, le coût d’entrée explose pour les nouveaux arrivants. Incidents historiques – biais discriminants chez Google en reconnaissance faciale ou en healthcare amplifiant inégalités raciales – ont coûté des milliards en réputation. À l’inverse, la transparence prouvée génère une prime de confiance : préférence clients, partenaires, investisseurs.

Gartner (Market Guide for AI TRiSM) souligne que les organisations avec gouvernance AI robuste voient adoption augmenter significativement.

Dans des secteurs comme le ferroviaire, l' automobile, l'énergie, l'aéronautique, la santé, la défense, la capacité à démontrer la maîtrise du risque (via des preuves systématiques et auditables) devient un avantage de marché majeur, car elle permet d’intégrer l’IA dans des systèmes certifiés.

Conclusion : Vers l’Ère de la Maîtrise et de la Prime de Confiance

L’histoire technologique enseigne que les leaders contrôlent la vitesse, pas seulement la course. En intégrant la conformité au cœur de l’architecture, vous évitez non seulement amendes dissuasives, mais construisez une machine de confiance industrialisée. Dans un monde post-modèles où les capacités explosent et les coûts chutent, la différence se jouera sur la capacité à déployer l’IA avec maîtrise absolue.

La prime de confiance deviendra la ressource rare des prochaines années : valorisation supérieure, résilience accrue, moat dans les zones premium. La conformité réinventée n’est pas un mur ni un frein ; elle est la fondation solide sur laquelle s’élève votre gratte-ciel d’innovation. Commencez le tri sévère aujourd’hui : votre leadership IA en dépend.

De la Vision à l'Exécution : Votre Feuille de Route vers le RegOS

Le "Pourquoi" est posé ; place à l'ingénierie du "Comment".

Cette série va disséquer l’industrialisation de la maîtrise technologique : de la fiabilisation des systèmes intelligents à la gouvernance souveraine des modèles, en passant par la résilience systémique et l’imputabilité des agents autonomes. Chaque étape converge vers la construction du RegOS : le noyau capable de transformer vos obligations complexes en un standard d’ingénierie IA de haute performance.

Références complémentaires

Gartner Top 10 Strategic Technology Trends 2026 : Prédiction du passage massif aux écosystèmes multi-agents en production.

Gartner IT Predictions 2026: Les réclamations légales pour "mort par IA" dépasseront les 2 000 cas faute de garde-fous.

Calendrier de mise en œuvre de l'EU AI Act (2026) : Échéance du 2 août 2026 pour la conformité des systèmes à haut risque.

OWASP Top 10 for Agentic Applications (Déc. 2025) : Guide crucial sur le détournement d'objectifs et l'abus d'identité des agents.

WEF Global Risks Report 2026 Briefing : L'incertitude mondiale impose une résilience par le design.

Anthropic Safety Update (2025) : Nouvelles protocoles pour éviter la dérive des modèles de raisonnement.

Deloitte AI Act Risk Assessment (2025) : Pourquoi le coût de non-conformité est désormais un risque existentiel.

Lego II - RegOS - Sac 1

Les opinions exprimées dans cet article sont strictement personnelles et ne reflètent pas nécessairement celles de mon employeur. Les contenus sont fournis à titre informatif et ne constituent pas un conseil juridique. Cet article explore des concepts architecturaux émergents et analyse des tendances de marché.